In Zeiten von Rohstoffknappheit, erhöhten Transportkosten und anderen potenziellen Hürden wie Strafzöllen suchen Unternehmen zunehmend nach Wegen, um geschäftskritische Störungen wie Lieferengpässe zu vermeiden. Die Minderung solcher Risiken erfordert jedoch viel manuellen Aufwand und hängt von der Verfügbarkeit von Expertenwissen und den richtigen Daten ab. Es liegt auf der Hand, dass eine erfolgreiche Risikominderung sehr zeitaufwändig sein kann und mit einer gewissen Unsicherheit einhergeht.

Der Bereich der künstlichen Intelligenz ermöglicht es Unternehmen, Ihre Daten zu analysieren und geeignete KI-Modelle einzusetzen, um Vorhersagen über potenzielle Lieferrisiken zu treffen und Unternehmen automatisch zu warnen. Aber wie funktioniert das in der Praxis? Wie erstellt man eine solche Lösung, und welche Herausforderungen gibt es bei ihrer Einführung?

GESCHÄFTSAUSWIRKUNGEN VON LIEFERUNTERBRECHUNGEN

Werfen wir zunächst einen Blick auf das Problem der Lieferengpässe und Lieferunterbrechungen. Um potenzielle Umsatzeinbußen zu vermeiden, versuchen Fertigungsunternehmen im Allgemeinen alles zu tun, um ihre Absatzprognosen zu erfüllen. Wie wir jedoch gerade in der Automobilindustrie sehen können, lassen sich Lieferengpässe bei bestimmten Komponenten wie Halbleitern oder Display-Panels nicht ohne weiteres abfedern und führen bei den meisten Automobilherstellern zu erheblichen Produktionsverzögerungen. Der Endkunde spürt diese Veränderungen in Form von verlängerten Lieferzeiten, steigenden Preisen oder der Nichtverfügbarkeit von Waren – besonders deutlich war dies im letzten Jahr bei PC-Komponenten wie Grafikprozessoren, auch GPUs oder Grafikkarten genannt.

Natürlich kann ein Unternehmen nicht immer effektiv auf die Ursachen von Lieferengpässen reagieren. Dennoch gibt es einige Möglichkeiten, möglichen Lieferengpässen vorzubeugen oder sie rechtzeitig zu erkennen, so dass die mögliche Interventionszeit maximiert wird und man auf die anstehende Situation bestmöglich reagieren kann. Künstliche Intelligenz (KI) bietet verschiedene Möglichkeiten, große Datenmengen zu analysieren, mögliche Warnsignale abzuleiten und die verantwortlichen Liefer- oder Bestandsmanager automatisch zu informieren, wenn eine potenzielle Bedrohung erkannt wurde.

JEDE KI-GESTEUERTE LÖSUNG IST ANWENDUNGSSPEZIFISCH UND HOCHGRADIG INDIVIDUALISIERT. KEINE IST WIE DIE ANDERE.

SKIZZIEREN SIE IHRE ERWARTUNGEN – DEFINITION DER ZUKÜNFTIGEN LÖSUNG

Bevor man mit der Implementierung einer KI-gesteuerten Lösung beginnt, ist es wichtig, die Erwartungen und Ziele zu definieren und hervorzuheben: Was soll erreicht werden? Wer ist die beabsichtigte Benutzergruppe? Welche Materialien, Standorte oder Produktgruppen werden in der ersten Version abgedeckt? Es ist sehr wichtig, den Umfang für den „Wertnachweis“ – den ersten Prototyp der erwarteten Lösung – klein zu halten. Die genaue Ausgestaltung des Prototyps wird sich von Fall zu Fall unterscheiden – ist die Aktivierung eines Alarms ausreichend, wenn die Versorgung gefährdet ist? Kann ein Instrument entwickelt werden, das Vorschläge zur Abschwächung des festgestellten Risikos enthält? Soll die Lösung in die bestehenden Planungsinstrumente integriert werden, oder kann sie ein eigenständiges Instrument sein? Sobald diese Fragen beantwortet sind, ist es an der Zeit, über das zukünftige Design nachzudenken.

DAS KONZEPT DES MASCHINELLEN LERNENS – ÜBERTRAGEN AUF UNSEREN ANWENDUNGSFALL

Das Konzept des maschinellen Lernens als Teilgebiet der künstlichen Intelligenz besteht darin, aus gegebenen Daten und Datenstrukturen sinnvolle Schlüsse zu ziehen. Zu diesem Zweck werden Algorithmen trainiert, um bestimmte Muster und Zusammenhänge aus großen Datensätzen zu finden und zu erkennen. In unserem konkreten Fall geht es darum, diese Daten zu identifizieren, die in Kombination miteinander auf eine mögliche Unterbrechung der Lieferkette hinweisen. Anschließend soll unsere Lösung in der Lage sein, diese so genau wie möglich vorherzusagen. Doch welche Daten werden benötigt, um das gewünschte Ergebnis zu erzielen? Die Beantwortung dieser Frage macht oft 80% des Aufwandes in einem KI-Projekt aus und kann nur individuell – Unternehmen für Unternehmen – beantwortet werden.

QUALITATIV GUTE UND AUSSAGEKRÄFTIGE DATEN – DER SCHLÜSSEL ZUM ERFOLG

Bei der Entwicklung von KI-gesteuerten Lösungen ist es hilfreich, wenn die benötigten Daten in Echtzeit und vor allem in guter Qualität zur Verfügung stehen. Solange Sie wissen, wo Ihre Daten aufbewahrt werden und wie Sie sie schnell und sicher abrufen können, spielt es eigentlich keine Rolle, wo Sie sie speichern. Ein Data Warehouse oder Data Lake, der immer auf dem neuesten Stand ist, kann jedoch eine große Hilfe sein, um einen schnellen Zugriff auf die Daten zu ermöglichen. Gerade in großen Unternehmen kann ein zentraler Datenspeicher oft ein echter Vorteil sein, da er es ermöglicht, die benötigten Daten mit Leichtigkeit zu erfassen.

DIE KUNST DER KÜNSTLICHEN INTELLIGENZ – HERAUSFINDEN, WAS SICH AUF DAS ERGEBNIS AUSWIRKT

Nachdem Sie Ihr Projekt erfolgreich skizziert haben, beginnt der schwierige Teil. Datenanalysten und Datenwissenschaftler versuchen, Schlüsselzahlen, Maßnahmen, Zahlen oder Ereignisse zu identifizieren, die sich auf das beobachtete Ergebnis auswirken können. Beispielsweise könnte ein Rückgang des Lieferanten-OTIF für ein bestimmtes Material darauf hindeuten, dass ein gewisses Risiko besteht, dass in Zukunft größere Mengen nicht geliefert werden. Wenn es zusätzliche Informationen gibt, dass das betreffende Material knapp ist (z. B. in Zeitungs- oder Webartikeln) und die Preise steigen, könnte dies ein weiterer Indikator für ein Risiko bei der Versorgung sein.

VORVERARBEITUNG DER DATEN UND HERAUSFINDEN, WAS GUT FUNKTIONIERT

Experten versuchen nun, all diese Daten zu sammeln und in einem Datenmodell zusammenzufassen. Dieser Schritt wird auch als Vorverarbeitung bezeichnet und nimmt in jedem Data-Science-Projekt einen großen Teil der Zeit in Anspruch. Nachdem die verschiedenen Daten gesammelt und zu einem Datenmodell zusammengeführt wurden, trainieren Datenwissenschaftler Algorithmen für eine Vielzahl von Algorithmen des maschinellen Lernens wie Support Vector Machine (SVD), Entscheidungsbäume, Zufallsforste oder Gradient-Boosted Decision Trees (z. B. XGBoost). Es ist besonders wichtig, historische Daten in Bezug auf die Zielvariable zu sammeln. In unserem Fall könnte dies zum Beispiel sein: ‚Potenzieller Stock-Out oder nicht?‘ kodiert mit 1 für „Wahr“ und 0 für „Falsch“. Diese historischen Daten werden für das spätere Training und die Validierung des Modells dringend benötigt.

TRAINING-TEST-SPLIT & VALIDIERUNG DES MODELLS

Um Modelle zu trainieren, werden nur 80 % der verfügbaren Referenzdaten verwendet – das ist der so genannte „Trainingssatz“. Sobald die Modelle trainiert sind, verwenden die Datenwissenschaftler die restlichen 20 % zur Validierung des Modells. Dies ist der so genannte „Test“- oder „Validierungs“-Satz. Die Leistung der einzelnen Algorithmen und die Frage, ob die Algorithmen zu präzise (‚over-fitting‘) oder zu allgemein (‚under-fitting‘) sind, werden anhand einer Vielzahl von Messgrößen bewertet. Schließlich werden mehrere trainierte Modelle zu einem Ensemble-Modell zusammengeführt, das oft noch bessere Ergebnisse liefert als die Einzelmodelle.

DER ERFOLG IHRER KI-LÖSUNG HÄNGT HAUPTSÄCHLICH DAVON AB, WAS IHR UNTERNEHMEN DARAUS MACHT

BEWERTUNGSMETRIKEN FÜR ML-MODELLE – MEHR ALS NUR EINE ZAHL?

Sobald der Prototyp fertig ist, ist es an der Zeit, die Leistung des maschinellen Lernmodells zu bewerten, indem man die Validierungsdaten in das Modell lädt und eine Reihe von Leistungskennzahlen vergleicht, um ein Verständnis dafür zu erhalten, wie gut der Algorithmus funktioniert. Je nach Datentyp, der vorhergesagt wird, können mehrere Leistungskennzahlen berechnet und miteinander verglichen werden.

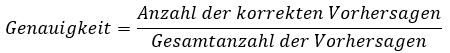

A: KLASSIFIZIERUNGSGENAUIGKEIT

(Beispiel: 995 richtige Vorhersagen /. 1000 Gesamtvorhersagen = 99,5%)

Besonders nützlich für Zielvariablen, die klassifiziert sind. Die Zielvariablen sollten diskreter Natur sein, d. h. die Beobachtungen können in klar abgrenzbare Kategorien oder Cluster unterteilt werden.

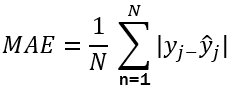

B: MEAN ABSOLUTE ERROR (MAE)

MAE steht für die durchschnittliche Differenz zwischen dem tatsächlichen und dem vorhergesagten Wert für alle Vorhersagen. Nehmen wir zum Beispiel an, dass man Filmbewertungen vorhersagen möchte, die Nutzer (die den Film noch nicht gesehen haben) auf der Grundlage ihrer historisch beobachteten Vorlieben wahrscheinlich bewerten würden.

Beispiel: Film X | Benutzer X | N = 1:

- y_j= Tatsächlicher Wert: 4

- y ̂j = Vorhersagewert: 6

Ausgehend von dieser einen Beobachtung liefert die MAE einen Wert von 2, d. h. die absolute Abweichung zwischen dem tatsächlichen und dem vorhergesagten Wert.

Es liegt auf der Hand, dass diese Leistungskennzahl sinnvoller ist, wenn eine größere Anzahl von Werten verwendet wird (z. B. N > 30). Bitte beachten Sie auch, dass diese Kennzahl größenabhängig ist. Die analysierten Größen müssen die gleiche Einheit haben, um verglichen werden zu können. Ob die MAE von „2“ als guter oder schlechter Wert angesehen wird, hängt von der jeweiligen Einheit und der zugrunde liegenden Skala ab.

C: VIELE WEITERE LEISTUNGSMETRIKEN

Bei der Entwicklung eines KI-Prototyps müssen Datenwissenschaftler genau wissen, welche Leistungskennzahlen sie auswählen und wie sie diese interpretieren sollen. Es gibt viel mehr, als wir hier aufgelistet haben. Aus Gründen der Komplexität werden wir in diesem Whitepaper jedoch nicht weiter ins Detail gehen.

STOCK-OUT-PROGNOSEN IN DER PRAXIS – UNSERE ERFAHRUNG

Kommen wir zurück zum Ausgangspunkt dieses Whitepapers – der Vorhersage von Versorgungsengpässen mithilfe von KI. Wir haben ein größeres Projekt in der deutschen Pharmaindustrie unterstützt, bei dem es um eine sehr ähnliche Lösung ging. Die Entwicklung verlief sehr gut, und die an dem Projekt beteiligten Datenwissenschaftler fanden geeignete Maßnahmen zur Vorhersage möglicher Lagerausfälle. Es war großartig zu sehen, wie ein so umfangreicher datenwissenschaftlicher Prototyp zum Leben erweckt wurde, vor allem wenn man den potenziellen Wert dahinter bedenkt. Dennoch ist dieser Showcase mit einigen Einschränkungen verbunden:

GRENZEN DES SHOWCASES

Einer der Hauptnachteile: Die Modelle des maschinellen Lernens mussten für jeden einzelnen Standort entwickelt und trainiert werden. Es war nicht ohne weiteres möglich, ein einzelnes Modell auf eine größere Anzahl von Standorten zu übertragen. Da der Kunde über weit mehr als 100 Standorte verfügte, bedeutete dies einen erheblichen Aufwand, wenn die Lösung für einen größeren Teil des Unternehmens genutzt werden sollte. Einige der Gründe dafür sind die unterschiedliche Datenqualität, die verschiedenen Geschäftsprozesse und die unterschiedlichen Datensätze, die für jeden Standort verfügbar sind.

VIELE FALLSTRICKE – ABER EINE STETIGE LERNKURVE

Obwohl die Ergebnisse für die Pilotstandorte sehr vielversprechend aussahen und der Prototyp von den Pilotanwendern auch gut genutzt wurde, war zu beobachten, dass die verwendeten Prädiktorvariablen meist voneinander abhängig waren. Das liegt daran, dass die Prädiktoren meist aus Key Performance Indicators (KPIs) bestanden, die ihrerseits bereits auf ähnlichen – wenn nicht gar denselben – Dateneingaben beruhten. Manchmal konnten wir nachweisen, dass mehrere KPIs teilweise auf denselben Dateninputs beruhten, was zu dieser gegenseitigen Abhängigkeit führte. Es hat sich gezeigt, dass nur wenige KPIs sehr relevant waren und den Großteil der vorhergesagten Ergebnisse erklären konnten.

Warum ist dies kritisch? Wenn es nur wenige Prädiktorvariablen mit hoher Gewichtung im Modell gibt, ist die Gesamtvorhersage sehr anfällig für Schwankungen der Datenqualität. Da die Prädiktorvariablen zusätzlich voneinander abhängig sind, wird der Effekt noch verstärkt.

UNTERSTÜTZEN SIE DEN BEWUSSTSEINSWANDEL – ERKLÄRBARE KI

Schließlich müssen wir auch die Interpretationsschwierigkeiten und die Skepsis der Endnutzer gegenüber KI-Tools berücksichtigen. Jedes KI-Tool ist nur so nützlich, wie es von der Zielgruppe produktiv genutzt werden kann. In unserem Fall lag der Schwerpunkt darauf, ein benutzerfreundliches Frontend zu schaffen, das sich an bewährten Verfahren des UI/UX-Designs orientiert und so wenig Fragen wie möglich offen lässt. Sobald die Lösung in Betrieb ging, konnten wir etwas sehr Interessantes beobachten, an das zuvor niemand gedacht hatte.

VERANTWORTLICHKEITEN IN EINEM KI-GESTEUERTEN UNTERNEHMEN

Wer trägt die Verantwortung für die Annahme oder Ablehnung einer Empfehlung des Tools zur Vorhersage von Lieferengpässen? Nehmen wir an, das Tool sagt Ihnen, dass kein Lagerausfall in Sicht ist – aber im nächsten Monat tritt er ein. Wer trägt die Verantwortung dafür? Was passiert, wenn sich ein Mensch über das Prognosetool hinwegsetzt, aber es stellt sich heraus, dass seine Entscheidung falsch war und das Unternehmen nun möglicherweise auf viel zu hohen Beständen sitzt?

SCHLUSSBEMERKUNGEN

Sie sehen, das Potenzial der KI kann sehr interessant und enorm sein – aber die Herausforderungen und Fallstricke können auch sehr schwer zu bewältigen sein. Forscher und Unternehmen versuchen gleichermaßen, Antworten auf diese Fragen zu finden.

Dennoch ist es wichtig, dass Unternehmen die Möglichkeiten der KI so schnell wie möglich nutzen, denn sie verfügen über alle Daten und Anwendungsfälle, für die sie KI einsetzen können.

HAFTUNGSAUSSCHLUSS

Alle Angaben in diesem Whitepaper beruhen auf ACOPAs Erfahrungen und Beobachtungen in realen Industrieprojekten. Dieses Whitepaper erhebt keinen Anspruch auf Vollständigkeit und gibt lediglich einen Überblick über die aktuelle Situation beim Einsatz von KI in der Industrie.

Autor: Fabian Ruehrnschopf

Leiter der Abteilung Digitale Transformation

([email protected])

Neueste Kommentare