Autor: Tai Nguyen

Einleitung

„Tell us what the future holds, so we may know that you are god.” (Isaiah 41: 23)

Bereits vor 700 Jahren vor unserer Zeitrechnung wurde die Fähigkeit zutreffende Prognosen zu erstellen als utopische Aufgabe identifiziert.[1] 2700 Jahre später hat sich der Schwierigkeitsgrad jener Aufgabe tendenziell sogar vergrößert. In der Wirtschaft müssen Unternehmen Ereignisse und Kundenverhalten treffend antizipieren. Dabei sind komplexe Wechselwirkungen und verschiedenste Parameter bei der Prognoseerstellung zu berücksichtigen. Anhand von vielen Projekten in unterschiedlichsten Branchen konnte festgestellt werden, dass von Kundenseite der Fokus meist bei der Auswahl des Prognosealgorithmus liegt, wobei die Datenqualität des Inputs oftmals als zweitrangig angesehen wird, wenn nicht gleich unberücksichtigt bleibt. In dem vorliegenden Whitepaper wollen wir Ihnen skizzieren, wie sie mittels des IBPs ihre Datenqualität verbessern können, sodass aus der scheinbar utopischen Aufgabe eine zu bewältigende Herausforderung wird.

Garbage In, Garbage Out…

Wie eingangs beschrieben, wollen wir uns mit der Datenqualität des Prognoseinputs beschäftigen, da diese, ganz nach der Redewendung „Garbage in, Garbage out“, maßgeblich zur Vermeidung von Planungsfehlern beiträgt. In der Regel handelt es sich bei dem Input um die Verkaufshistorie. Das vorgestellte Prinzip kann allerdings mit jeder beliebigen Kennzahl durchgeführt werden.

IBP bietet bei dem Data Cleansing diverse Algorithmen und Methoden an. Eines der Methoden ist die Outlier Correction. Hierbei werden sogenannte Outlier identifiziert und je nach Wunsch korrigiert. Diese Datenpunkte spiegeln in der Regel ein untypisches Verhalten wider, welches zu falschen Schlussfolgerungen und damit einhergehend zu realitätsfernen Prognosen führen kann. Die Entstehung eines Outliers ist auf verschiedenste Ursachen zurückzuführen (bspw. Lieferengpässe, einmaliger Großauftrag, sonstige Ereignisse).[2]

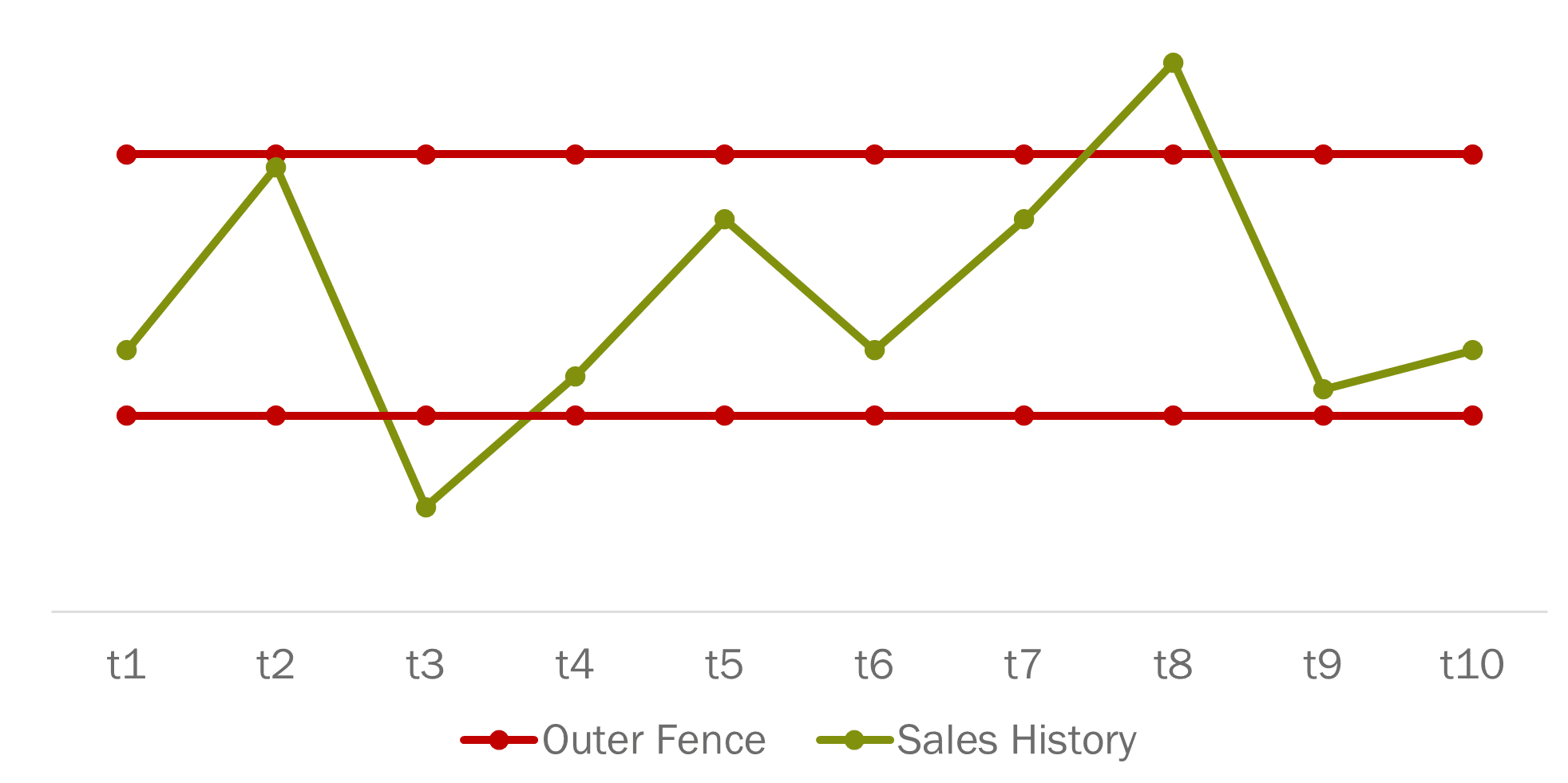

Abbildung 1: Outlier Detection

Vereinfacht gesagt, wird für die Identifizierung von Outliers Ober- und Untergrenzen als Toleranzgrenzen festgelegt (hier dargestellt in rot). Sobald ein Datenpunkt diesen Toleranzbereich nach unten oder nach oben überschreitet, wird der Punkt als Outlier identifiziert (hier in t3 und t8). Im nächsten Schritt kann ein Outlier beispielsweise durch den Mittelwert oder durch den Median automatisch ersetzt werden.

Vertrauen ist gut. Kontrolle ist besser

Obwohl eine automatische Datenbereinigung sehr attraktiv scheint, sollte das Ergebnis vom Planer überprüft werden. Hierbei bietet IBP Alert Kennzahlen an, die korrigierte Werte in einer Zahlenreihe markieren. Diese können dann bestätigt oder ggf. korrigiert werden. Das IBP Excel Add-On bietet bei diesem Prozess ein gewohntes und übersichtliches Umfeld.

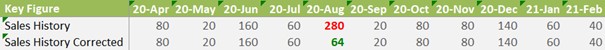

Im nachfolgenden Beispiel wurde in der Sales History ein Outlier im Monat August 20 identifiziert und durch den Alert in rot eingefärbt. Dieser Wert wurde durch den Algorithmus ersetzt (hier in grün).

Abbildung 2: Outlier Correction im Excel Add-On

Sobald die Zahlenreihe bereinigt wurde, kann diese in den Prognosealgorithmus einfließen.

Fazit

Wir hoffen, dass Ihnen dieser kurze Exkurs gefallen hat. Selbstverständlich kann in diesem kurzen Artikel die gesamte Komplexität der Outlier Correction nicht abgebildet werden. Falls sie Fragen haben, lassen sie es uns bitte in den Kommentaren wissen. Gerne wären wir ebenfalls für ein Gespräch über ihre speziellen Anforderungen und Herausforderungen offen. Kontaktieren sie uns hierbei gerne per Mail.

__________

[1] Vgl. Rob J. Hyndmann; George Athanasopoulos, 2018, Forecasting: principles and practices

[2] Vgl. https://demand-planning.com/2020/02/05/how-to-identify-treat-outliers-in-demand-planning/

Neueste Kommentare